Sempre più realistici, credibili e accurati nell’esecuzione. Di cosa stiamo parlando? Dei contenuti generati con l’intelligenza artificiale e di un problema a loro connesso: la disinformazione e il deepfake. Ma come lo stanno affrontando sia le piattaforme che forniscono i servizi sia quelle che diffondono contenuti? Andiamo con ordine. In questo settore specifico si sta puntando a una rogolamentazione sulla linea dell’Artificial Intelligence Act, una proposta di normativa che era stata presentata nel 2021 ed è stata votata nel 2024. Qui l’esigenza principale è la trasparenza. Si cercano metodi e strumenti per mettere nelle condizioni gli utenti di capire quando sono di fronte a contenuti reali o a contenuti generati artificialmente. Una premessa è doverosa. Le evoluzioni sono molto rapide: si avvicendano servizi sempre più innovativi e nuove problematiche da affrontare. Questo significa che stare al passo è complesso ed è difficile avere una parola definitiva sul tema.

Quali sono le piattaforme di AI più note e a cosa servono

Cominciamo dalle basi, ovvero da un piccolo elenco di comodo delle piattaforme più note per generare contenuti di intelligenza artificiale. OpenAI infatti ha fatto da pioniere con ChatGPT, ma ormai è un florilegio. In generale i tool di AI dei vari operatori, da Microsoft a Google a Adobe (o altri ancora), hanno caratteristiche tra loro leggermente differenti. C’è chi fornisce servizi legati a contenuti testuali, chi per le immagini, chi per i video e chi per audio.

Piattaforme per generazione di testi a partire da indicazioni testuali:

- Gemini (ex Bard)

- Copilot

- Jasper.Ai

- WriteSonic

Piattaforme per generazione di immagini a partire da indicazioni testuali:

- Midjourney

- Adobe FireFly

- DALL•E

- Leonardo

Piattaforme per generazione di audio a partire da indicazioni testuali:

- Soundful

- FakeYou

Piattaforme per generazione di video a partire da indicazioni testuali:

- Invideo

- CapCut

- Pictory

In arrivo Sora di OpenAi e Lumiere di Google.

L’AI nel digital, il rischio della disinformazione

Un sondaggio realizzato da Global Risks Report fa capire perché è molto sentita l’esigenza di una normativa e di strumenti che tutelino la trasparenza. Secondo quanto raccolto da questa ricerca, infatti, l’avvento dell’Intelligenza Artificiale rappresenta uno dei più grossi rischi per l’umanità. Questo perché a questo tipo di contenuti è associato il potenziale rischio di disinformazione. Molte immagini e testi “artificiali” sono presenti nei servizi che usiamo ogni giorno. Cominciare a identificarli è fondamentale. Come si potrà, infatti, distinguere un articolo con informazioni verificate rispetto a uno scritto da un’AI? Come si identificheranno le immagini o i video “artificiosi” rispetto a quelli reali? Cosa ci aiuterà a distinguere ciò che è vero da quello che è stato creato da strumenti di machine learning? Gli operatori AI, ma anche le piattaforme che diffondono contenuti, si stanno muovendo per fornire delle linee guida a tutela degli utenti.

Le piattaforme di AI, le norme a cui devono attenersi

DALL•E e Midjourney, le regole che devono osservare

La regolamentazione dell’Unione Europea è intervenuta su DALL•E e Midjourney, due delle piattaforme di intelligenza artificiale più note per generare immagini a partire da indicazioni testuali. Dovranno rendere distinguibili le loro elaborazioni per ridurre il rischio che vengano impiegate come fotografie reali e alimentino il circuito della disinformazione.

OpenAI, l’alleanza con le testate giornalistiche per i diritti d’autore

Da quando ChatGPT ha fatto il suo debutto sono accadute tante cose e si sono aperti diversi fronti. Uno di questi riguarda i diritti d’autore del materiale con cui il sistema di machine learning è stato addestrato. Spesso si tratta di testi di scrittori, giornalisti, testate giornalistiche che possono essere utilizzati se pagati. Gli sviluppatori li hanno sfruttati per addestrarli ma non è stato riconosciuto un compenso economico. La giustificazione? I sistemi di intelligenza artificiale sono ancora in una fase sperimentale e hanno bisogno di una grande quantità di dati per essere allenati. Dopo essere stata citata in giudizio dal New York Times, ChatGPT sta tentando di correre ai ripari. Ha annunciato di avere stretto degli accordi con Le Monde e il gruppo editoriale spagnolo Promotora de Informaciones (Prisa). Lo scopo è utilizzare (legittimamente) i loro contenuti per allenare le AI. Una buona news anche per l’affidabilità.

Contenuti AI sui social e sui siti, come renderli distinguibili

Appunto perché siamo in una fase iniziale, ancora più che di assestamento, ogni giorno è quello buono per una nuova notizia. Si parla sempre di più di intelligenza artificiale e di contenuti generati, che siano testi, video, immagini o audio. A confrontarsi con loro devono essere anche le piattaforme su cui possono atterrare, dai siti ai social. Per limitare il dilagare della disinformazione, che sarebbe alimentata dalla loro presenza poco riconoscibile e controllata, è necessario per loro trovare delle soluzioni. Obiettivo? Rendere questi contenuti distinguibili, tutelando la trasparenza. Ecco alcune strategie messe in campo dai vari operatori.

Google, un lavoro di indicizzazione che penalizza lo spam

ChatGPT e Gemini sono piattaforme di intelligenza artificiale utili a generare testi automatici a partire da prompt testuali. Con loro si possono scrivere articoli che, come qualsiasi altro contenuto, vengono indicizzati da Google. Big G ha sempre dichiarato che i requisiti di valore che prende in considerazione sono quelli legati all’acronimo EEAT. Ovvero expertise, experience, authoritativeness, trustworthiness (competenza, esperienza, autorevolezza, affidabilità). E questo vale sia per testi scritti da autori, sia per quelli generati da AI, senza fare distinzioni di specie basati sulla modalità di creazione. A marzo 2024 ha integrato a questa indicazione di base una postilla relativa allo spam. Ovvero “l’uso dell’automazione, inclusa l’IA generativa, costituisce spam se lo scopo principale è manipolare il ranking nei risultati della Ricerca”. L’obiettivo finale non è tanto penalizzare i singoli contenuti a livello SEO, ma scoraggiare “gli abusi di contenuti su larga scala”. Legati per esempio alle content factory.

YouTube, le etichette per i contenuti AI

È recente la notizia che YouTube stia lavorando perché i creator abbiano delle label (etichette) da inserire sui contenuti nel caso in cui questi fossero generati con intelligenza artificiale. Questo provvedimento è molto importante in questo momento. Sono varie le aziende, tra cui Google e OpenAI, che stanno annunciando piattaforme di video generati con AI a partire da indicazioni testuali (prompt). YouTube vuole quindi intervenire con delle soluzioni sempre a tutela della trasparenza. È necessario rendere esplicito quando ci sono video realizzati con AI, soprattutto se hanno eventi, scene, luoghi e persone potenzialmente reali.

Meta, i contenuti AI ben identificati

Nella stessa direzione di etichettatura va Meta con Instagram e Facebook. Lo ha annunciato a febbraio 2024 e lo metterà in atto a partire da maggio 2024. La label “Made with AI” verrà inserita su una più vasta gamma di contenuti. Non saranno solo i video ad averla, ma anche le immagini e gli audio. Servirà a fare identificare agli utenti contenuti che mostrano, per esempio, una persona che ha fatto o detto cose che non ha fatto o detto. L’etichetta sarà utilizzata sia sui contenuti identificati da Meta sia su quelli che gli utenti dichiareranno in fase di caricamento.

Intelligenza artificiale e trasparenza

Contenuti AI, i tool per identificarli

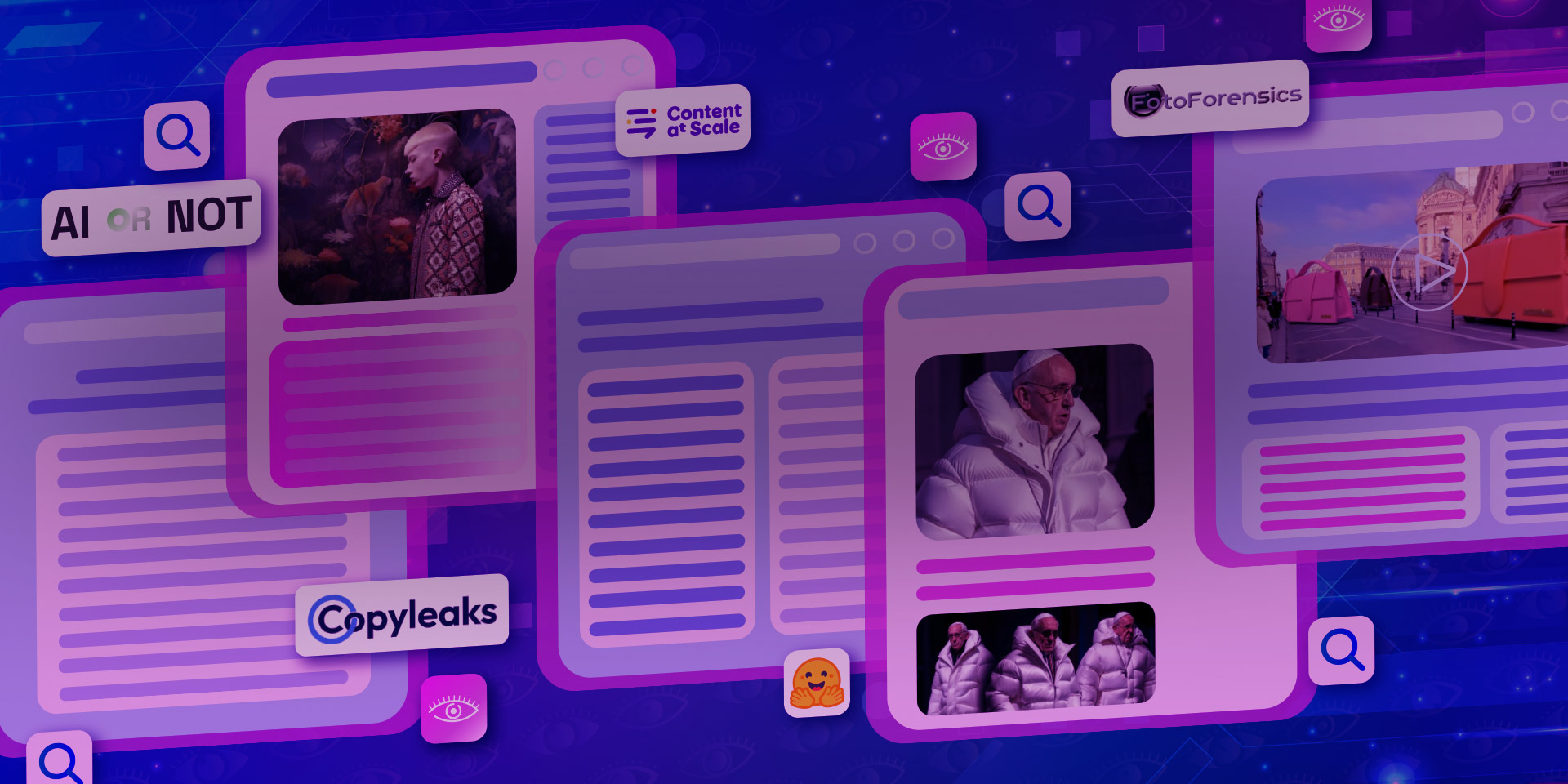

Apriamo il capitolo con una news che potrebbe non essere delle migliori. Uno strumento che viene utilizzato da esperti e giornalisti per verificare la veridicità di notizie diventate virali è CrowdTangle. Questo è utile anche nel caso si debbano analizzare contenuti generati da AI. Il problema? Lo strumento verrà ufficialmente dismesso ad agosto 2024. Salvo cambiamenti. Esistono, però, altri tool per verificare se un contenuto è reale o generato con l’intelligenza artificiale. Per quelli testuali per esempio si può usare CopyLeaks o Content At Scale. Per le immagini sono disponibili strumenti come Optic AI or Not, Hugging Face, Foto Forensics. Content At Scale di recente ha aggiunto anche un image detector alla suite di prodotti. In generale per verificare le immagini con questi strumenti basta o inserirle nel sistema o mettere la loro url. Il risultato è una valutazione percentuale legata alla probabilità che l’immagine sia creata con AI.

Contenuti AI, affinare l’occhio non è una cattiva idea

Sicuramente i tool possono aiutare, ma anche l’occhio vuole la sua parte. Più saremo immersi in contenuti realizzati con l’intelligenza artificiale, più sarà necessario affinare la sensibilità visiva. Questo si può fare per esempio ingrandendo le immagini e analizzando con attenzione le superficie delle cose che ritraggono. Se sono troppo lisce e patinate è probabile che si tratti di un’artificiosità. Anche le parti anatomiche incongruenti possono aiutare a identificare una foto generata da intelligenza artificiale. In generale è buona pratica verificare le fonti e fare il confronto con altre immagini che su Google. Queste possono o confermare o smentire quello che si sta guardando. Rimane poi sempre valida l’indicazione di affidarsi ad esperti di comunicazione digitale, in grado di consigliare le misure necessarie per garantire affidabilità e trasparenza online.